当你爱上 ChatGPT 的幻觉

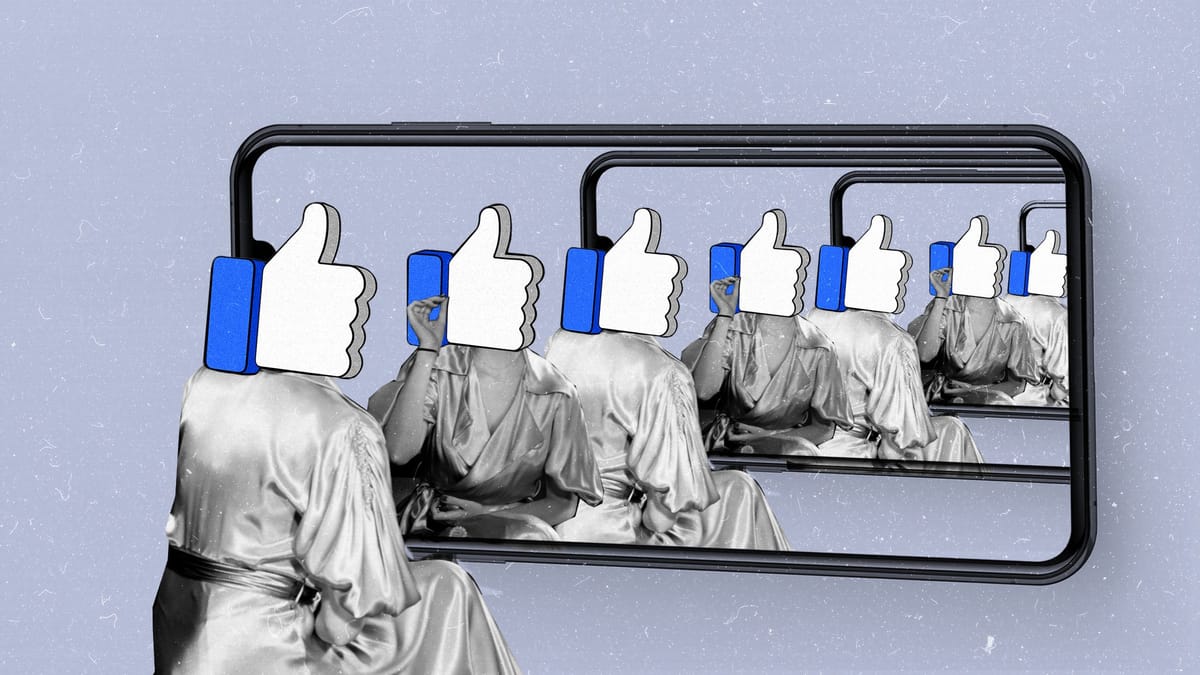

ChatGPT 的便利性和看似权威的输出,让人们放弃了批判性思维,甘愿被困在聊天室茧房之中。

也许你已经注意到 ChatGPT 或者是 DeepSeek 在生成内容时难免会出错,有时甚至会编造出完全虚假的信息。这种现象在人工智能领域有个专有名词——幻觉(hallucination)。想象一下,你向 ChatGPT 提问,它自信满满地给出一个答案,可这个答案却可能是凭空捏造的。更令人担忧的是,它有时还会附上看似真实的参考资料,让人误以为一切都经过了严谨验证。

当用户与 ChatGPT 互动时,他们可能会不自觉地相信这些错误信息,甚至将它们融入自己的认知体系。这种信任,可能催生一种全新的媒体效应——研究者称之为聊天茧房(Chat-Chamber)。这个效应恰好处于“回音室”(echo chamber)和“过滤气泡”(filter bubbles)的交汇处。回音室指的是人们只接触与自己观点一致的信息,像回声一样不断强化原有信念;而过滤气泡则是算法根据用户偏好过滤内容,进一步隔离不同的声音。ChatGPT 可能在无意中放大这两种效应,让用户陷入一个由 AI 构建的信息茧房,里面充斥着偏见和未经核实的内容。

为了探究这一现象,研究者们在论文《The chat-chamber effect: Trusting the AI hallucination》中选择了一个既敏感又有社会意义的话题:印度和爱尔兰的 LGBTQIA+ 民选代表。他们设计了一项实验,试图揭示 ChatGPT 在提供信息时的准确性,以及用户对其输出的信任程度。为什么选择这两个国家呢?因为印度和爱尔兰在 LGBTQIA+ 权利的演进上有着相似之处。两国都曾深受英国殖民统治影响,继承了维多利亚时期的道德法律,将同性恋定为非法。直到 1993 年爱尔兰废除相关法律,2018 年印度也迎来了类似的改革,才让这一群体逐渐走进公众视野。如今,两国都涌现出少数公开身份的 LGBTQIA+ 政治家,为研究提供了一个观察窗口。

研究问题

这项研究的核心围绕三个问题展开。首先,ChatGPT 会不会在 LGBTQIA+ 身份问题上提供错误信息?当被问及印度和爱尔兰的 LGBTQIA+ 民选代表时,ChatGPT 是否会给出不准确甚至完全虚构的答案?其次,ChatGPT 会不会加剧像回音室和过滤气泡这样的媒体效应?最后,用户会不会批判性地看待 ChatGPT 的回答,并主动核实这些信息?

研究方法

为了解答这些问题,研究者他们采用了“连续研究设计”(sequential research design),先用实验收集数据,再通过访谈深入挖掘。这种方法的好处在于,既能看到表面的现象,又能探究背后的原因。实验分为两个阶段,分别在印度和爱尔兰进行。每个阶段又分为两步:第一步是实验研究,第二步是半结构化访谈。

在印度,研究者招募了 50 名参与者,来自新德里、海得拉巴等大城市,也有来自较小城镇的居民。他们被随机分为两组:一组使用 ChatGPT 3.5,一组使用 Google 搜索引擎。任务很简单——回答关于印度 LGBTQIA+ 民选代表的问题,比如“印度有没有 LGBTQIA+ 的立法议员(MLA)?”、“国会议员(MP)呢?”、“地方村务委员会(Gram Panchayat)有吗?”参与者有 120 分钟时间,通过 Zoom 远程完成任务,答案录入 Google 表单。

接着,在爱尔兰一所大型公立大学招募了 64 名学生,同样分为两组。任务调整为爱尔兰的背景,比如“爱尔兰有多少 LGBTQIA+ 的地方县议员?”、“下议院议员(TD)有多少?”、“欧洲议会议员(MEP)呢?”、“总理(Taoiseach)和副总理(Tánaiste)的情况如何?”规则与印度阶段一致,参与者在线完成任务。

实验结束后,研究者从两组中各抽取部分参与者进行半结构化访谈,总计 23 人(印度 16 人,爱尔兰 7 人)。访谈围绕三个主题展开:一是参与者从 ChatGPT 或 Google 中学到了什么,他们的反应如何;二是这些答案是否强化了他们的现有信念,还是提供了新的视角;三是他们有没有核实这些信息,比如用其他工具查证,或与他人讨论。

研究发现

发现一:ChatGPT 的“幻觉”频现

首先,ChatGPT 在提供 LGBTQIA+ 民选代表信息时,频频出错。在印度阶段,关于立法议员(MLA)的问题,ChatGPT 只在 25 次回答中有 3 次正确,准确率仅 12%。它要么错误地宣称印度从未选出过公开的 LGBTQIA+ MLA,要么干脆编造名字,比如把知名异性恋政治家或活动家错标为 LGBTQIA+。关于国会议员(MP),它表现稍好,48% 的回答正确指出印度没有此类代表,但仍有 13 次回答出错,甚至杜撰出不存在的议员。至于地方村务委员会,ChatGPT 更是全军覆没,25 次回答无一正确,要么说没有,要么捏造名字。相比之下,Google 用户的正确率高达 96%、100% 和 84%,差距一目了然。

爱尔兰的情况也惨不忍睹。关于地方县议员,ChatGPT 一次也没答对,只是建议用户去查官网或咨询组织。关于下议院议员(TD),34 次回答中只有 1 次正确,其余要么把非 LGBTQIA+ 人士错标,要么含糊其辞。欧洲议会议员(MEP)和总理相关问题也好不到哪去,只有少数几次正确提及 Leo Varadkar(爱尔兰首位公开同性恋身份的总理)。Google 组的表现依然更优,正确率从 30% 到 60% 不等。尽管 Google 也不是完美无缺,但 ChatGPT 的“幻觉”显然更严重,暴露了它在处理具体事实时的短板。

发现二:聊天茧房效应

访谈揭示了一个更深层的问题:ChatGPT 的错误信息不仅未被质疑,反而被用户欣然接受,强化了他们的信念,形成了一种聊天茧房效应。在印度,一位参与者被 ChatGPT 误导,认为某政治家是同性恋,还自圆其说:“他没胡子,长头发,和妻子有矛盾,肯定是 gay。”另一位参与者也表示,ChatGPT 的答案改变了她对某政治家的认知,她直接相信了这些虚构信息。类似的情况在爱尔兰也有,参与者 2 因某政治家支持 LGBTQIA+ 议题,就接受了 ChatGPT 的错误标签,认为这“合情合理”。

这种现象的背后,是用户对 ChatGPT 输出的倾向性信息缺乏警惕。当答案与他们的社会背景或期待一致时,比如印度对 LGBTQIA+ 接受度上升,或爱尔兰的婚姻平等改革,他们更容易全盘接受。这种封闭的反馈循环,就像一个茧房,把用户困在由 AI 构建的信息世界里,外界的真相难以渗透进来。

发现三:盲目的信任

更令人担忧的是,用户对 ChatGPT 的信任近乎盲目,几乎无人主动核实信息。在访谈中,许多人称 ChatGPT “方便”“可靠”,甚至取代了 Google。一位印度的参与者说:“Google 太费劲了,信息一堆垃圾,还不靠谱。ChatGPT 简单直接,连老师都不知道的它都能答。”另一位爱尔兰的参与者也表示:“它不完美,但答案看起来还行,查其他来源太麻烦了。”这种信任源于 ChatGPT 的用户体验——答案清晰、具体,还带数据,让人觉得“权威”。

还有一位参与者甚至说:“ChatGPT 的回答满是数据和统计,用简洁的语言组织得好。如果不知道,它也会告诉你。这种能力让我放心,所以没必要再查。”相比之下,Google 用户更倾向于核实,因为搜索结果繁杂,难以分辨真假。也有参与者抱怨:“Google 太死板,分不清哪个来源重要,验证花的时间比预想的多。”这种对比凸显了一个事实:ChatGPT 的设计让用户过度依赖它,而忽视了准确性的重要性。

研究结论

实验证明,ChatGPT 在回答 LGBTQIA+ 民选代表问题时错误频出,用户却往往深信不疑,甚至不屑于核实。这种盲目的信任,催生了聊天茧房效应——一种介于回音室和过滤气泡之间的新媒体现象。用户在与 ChatGPT 的互动中,接受了大量未经验证的信息,这些信息有时与他们的信念吻合,有时则悄然塑造了他们的认知。

研究者指出,这种效应的根源在于 AI 的“幻觉”和用户的高信任度结合在一起。ChatGPT 的便利性和看似权威的输出,让人们放弃了批判性思维,甘愿被困在聊天室茧房中。这不仅对个人认知构成威胁,也可能放大社会偏见,尤其是在涉及像 LGBTQIA+ 这样的边缘群体时。

不过,这项研究也有局限,它只基于 ChatGPT-3.5 版本。未来,研究者建议将视野扩展到其他模型,如 Bard、Gemini 或 Claude,验证这一效应的普遍性。同时,他们呼吁技术开发者在设计 AI 时,注重提升信息准确性,并鼓励用户培养批判性思维。而作为用户的我们,我们需要在享受技术红利的同时,保持清醒,去质疑、去核实,才能不被“幻觉”迷昏头了。